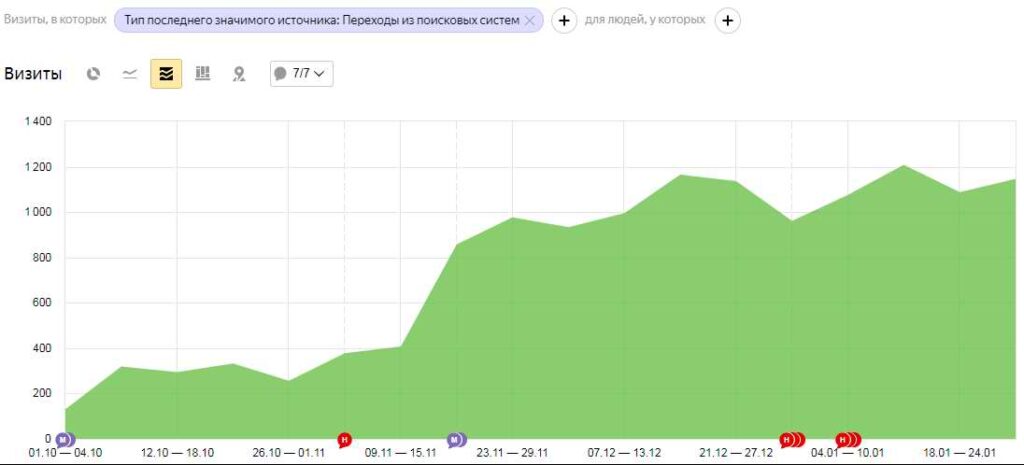

Как за четыре месяца мы увеличили трафик в 4 раза и улучшили конверсию в 3 раза

В период с октября 2020 года по февраль 2021 мы увеличили трафик с 1312 до 4924 пользователей в месяц. В данный момент работы над сайтом продолжаются.

Сравнение с аналогичным периодом за прошлый год:

Что делали и как этого добились

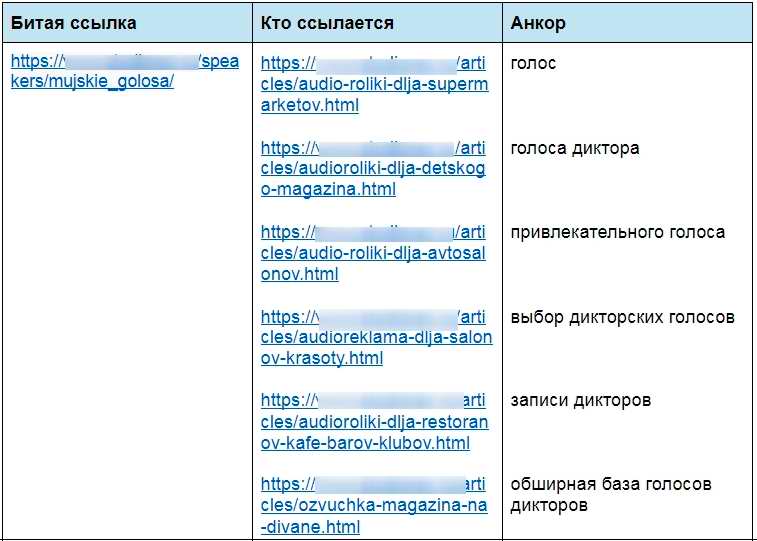

Убрали битые ссылки

Спарсили сайт, нашли страницы с 404 ответом, подготовили такую таблицу с анкорами, битой ссылкой и страницей-донором:

Теперь поисковому роботу ничего не мешало нормально ходить по сайту.

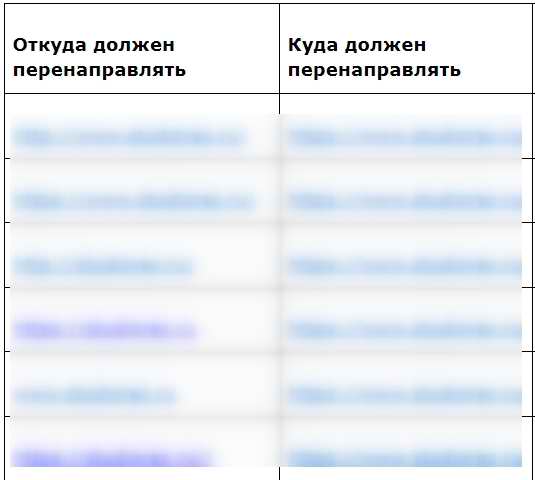

Настроили редиректы для главной и внутренних страниц

Чтобы в индексе было только главное зеркало сайта. Предварительно сделали такую карту редиректов, чтобы ничего не упустить:

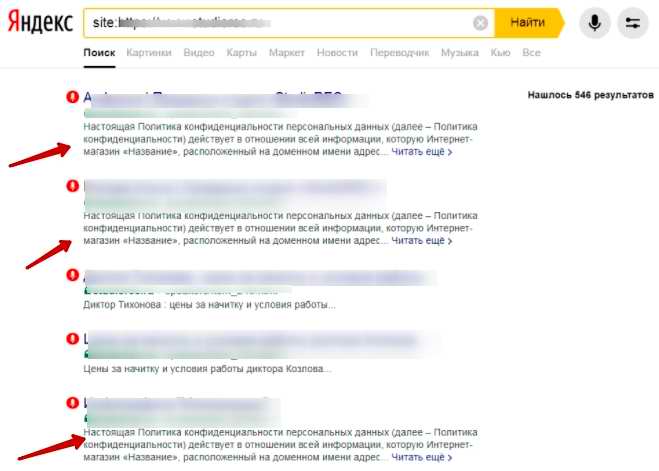

Избавились от индексируемых внутренних дублей

На каждой странице присутствует текст политики конфиденциальности. Он большой, на 10К символов. Текст не виден пользователям, но его видели поисковые роботы. Содержимое проиндексировалось.

Получилась ситуация, когда один текст повторялся на 90% страниц. Кроме того, он размывал релевантность отдельно взятой страницы. Из-за чего роботы не могли корректно определить тематику сайта.

Чтобы исправить закрыли текст политики конфиденциальности в тег <noindex>. Вот так:

| <noindex> Текст политики конфиденциальности. </noindex> |

Такое решение улучшило релевантность и помогло избавиться от внутренних дублей.

Избавились от мусора в индексе

Ненастроенный robots.txt привел к тому, что мусорные страницы попали в индекс поисковых систем. Речь про страницы оформления заказа, поиск, корзину. Чтобы исправить ситуацию, решили использовать мета роботс.

| <html> <head> <meta name=“robots” content=“noindex,nofollow”> </head> |

Простая настройка директивы robots.txt в этом случае не помогла бы. Потому что она действует как запрет на посещение роботом страницы.

А с помощью мета роботс мы добились своей цели — убрали все мусорные страницы из индекса.

Собрали семантику, проработали структуру

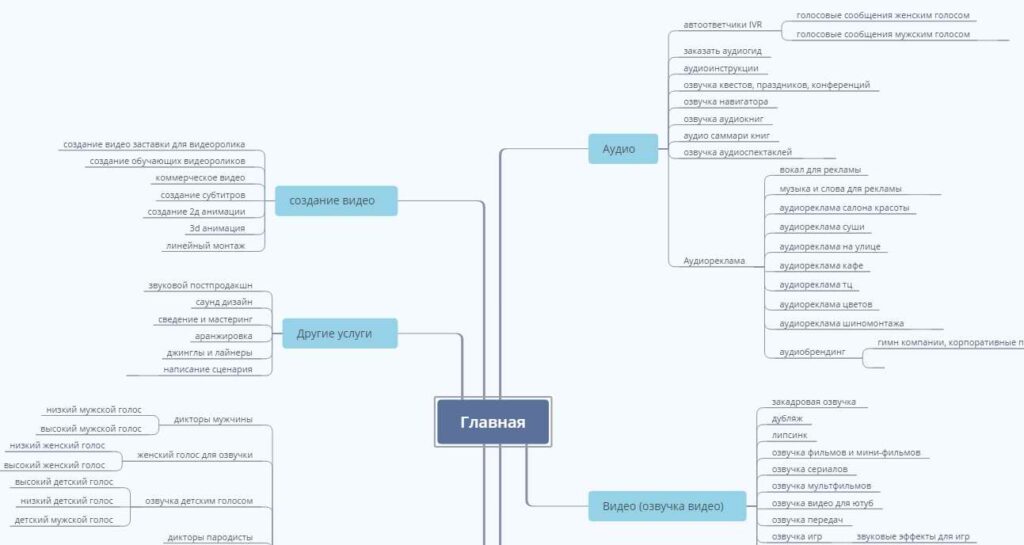

Собрали базовые маски, спарсили ключи, почистили мусор. Все кластеризовали и распределили по посадочным страницам. На основе собранной семантики сделали структуру, которая помогает визуализировать точки роста. Вот фрагмент визуализированной структуры:

Дополнительно сделали новую структуру меню. Предложили реализовать вариант с выпадающими пунктами, чтобы минимизировать уровень вложенности.

Проработали метатеги — тайтлы, дескрипшены, H1

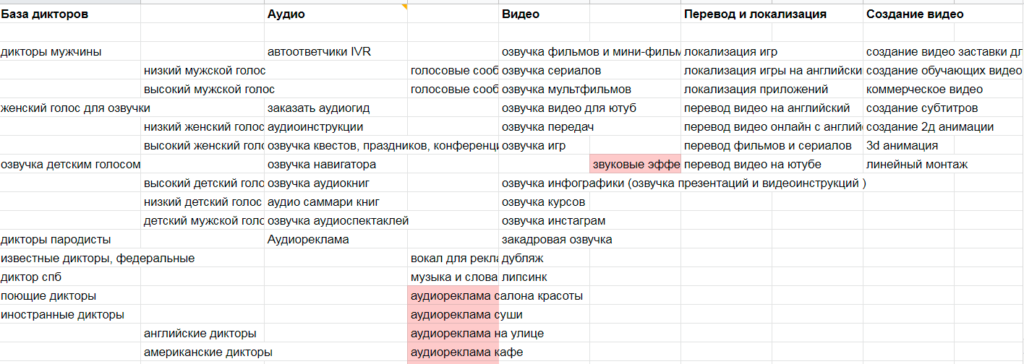

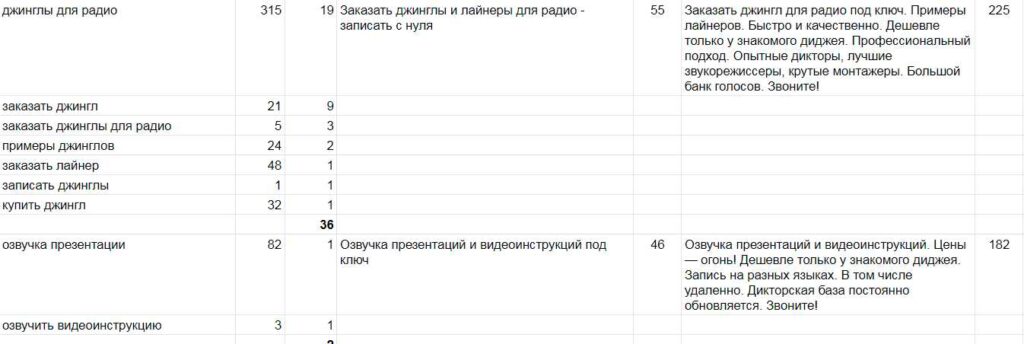

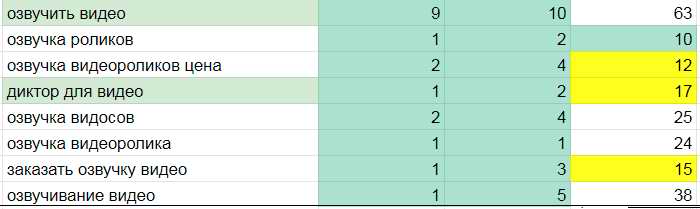

С учетом конкурентности и частотности ключей по каждому кластеру подготовили вот такой документ с метатегами:

Разместили их на существующих страницах. Так выглядит динамика позиций на примере одного из кластеров после добавления метатегов:

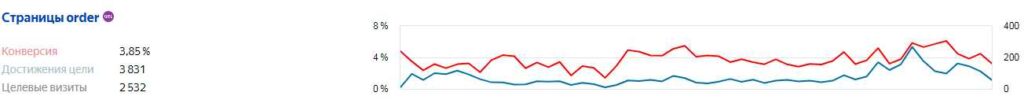

Как дела с конверсией

Улучшили количество обращений с сайта в 3 раза — с 57 до 167.

С учетом сезонности ожидается дальнейший рост этой цифры.

Что дальше

Сайт на самописной CMS, поэтому некоторые важные моменты плохо реализованы. Так как шаблонных решений найти нельзя, приходится допиливать все вручную. Сейчас, например, работаем над исправлением ошибки генерации пустых страниц в блоге.

Еще одна серьезная проблема — дубли карточек товаров. Они находятся не в корне, поэтому генерируется множество дублей. Все из-за того, что одна и та же карточка может крепиться к разным категориям. Тоже работаем над исправлением.

В глобальном плане планируем развивать англоязычную версию сайта, чтобы привлечь еще больше трафика. Для этого нужна настройка hreflang и корректная перелинковка между версиями.